In un’ansia da compliance all’AI Act, Meta ora permette, con un certo ritardo non casuale, di fare quello che in gergo tecnico si chiama “opt-out”: di default le immagini e le caption finiscono quindi nel modello di IA, ma è possibile a posteriori negare, appunto, il consenso

San Francisco. “È ufficiale. Firmato alle 10:33. Era anche in tv. Il mio è davvero diventato blu. Ricordatevi che domani inizia la nuova regola di Facebook (alias…) nuovo nome Meta) dove possono usare le tue foto”. Iniziava così – sgrammaticature e parentesi incluse – una catena di sant’Antonio che imperversava sulle bacheche di boomer e in generale inconsapevoli digitali qualche mese fa. All’epoca si “negava il permesso” a Zuckerberg perché si temeva il passaggio del social più diffuso al mondo a pagamento, cosa che non è mai successa, e ovviamente non succederà mai, a meno che Elon Musk non faccia una scalata aggressiva anche al colosso di Menlo Park.

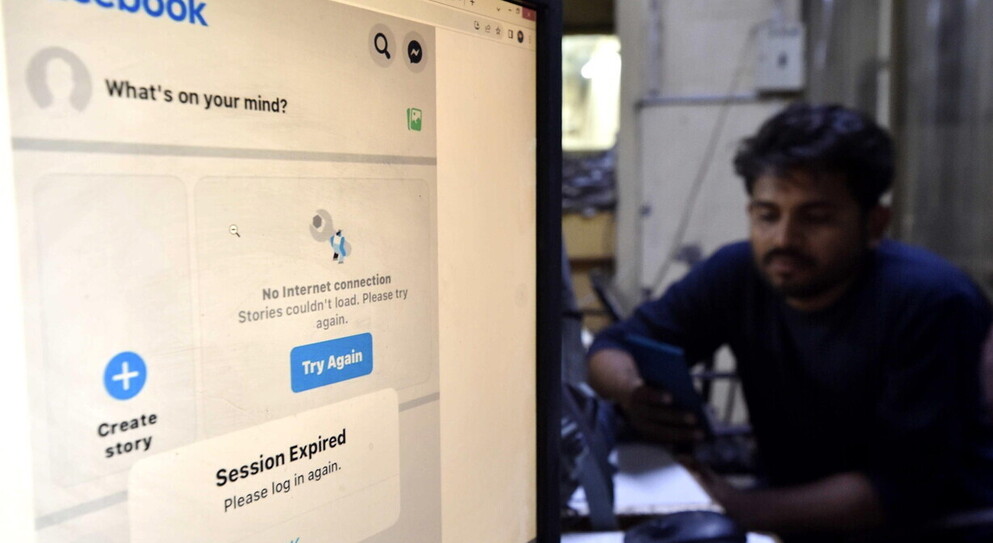

Oggi però quel tema torna a essere tristemente attuale, dato che è noto che ormai da mesi Meta, l’azienda che detiene Facebook, Instagram e Whatsapp, ha utilizzato tutto il materiale postato pubblicamente dagli utenti – a quanto pare, le conversazioni private dovrebbero essere escluse – per allenare il suo modello di intelligenza artificiale, Llama 3. Il modello, avversario del GPT-4 di OpenAI e di quelli del Claude di Anthropic, è tra i più potenti al mondo, con una base di 400 miliardi di parametri. Rispetto ai suoi concorrenti, è stato anche tra i meno costosi da allenare, dato che il lavoro lo abbiamo fatto noi negli ultimi 15 anni: tutte le foto con didascalia, tag delle persone nelle immagini e altri succosi dettagli che abbiamo generosamente fornito alla piattaforma sui nostri profili ha evitato al gigante della Silicon Valley (che comunque ha investito più di chiunque altro sul tema IA negli ultimi due anni) di appaltare come i suoi competitor il “labeling”, l’etichettatura dei contenuti, a qualche lavoratore sottopagato in India o nel continente africano. Non usi i social e ti senti quindi al sicuro? Niente affatto, perché come dichiara Meta nella sua policy, “anche se non utilizzi i nostri prodotti e servizi o non disponi di un account, potremmo comunque elaborare le tue informazioni per sviluppare e migliorare l’intelligenza artificiale su Meta”: basta che un amico abbia caricato una foto di te sui social con il tuo nome e cognome per finire quindi schedati.

Forse in un’ansia da compliance all’AI Act, Meta ora permette, con un certo ritardo non casuale, di fare quello che in gergo tecnico si chiama “opt-out”: di default le immagini e le caption finiscono quindi nel modello di IA, ma è possibile a posteriori negare, appunto, il consenso. Il processo dovrebbe essere facile, ma siamo pur sempre nel capitalismo della sorveglianza, e quindi l’azienda californiana ha tutto l’interesse a rendere il processo più complicato del dovuto. Per abilitare l’opzione bisogna dunque passare dalle forche caudine di una lunga serie di click a partire dall’help center di Instagram. Per Facebook è necessario fornire tutta una serie di informazioni di dettaglio sulla propria scelta, che potrebbe far desistere chi non sia veramente molto motivato a procedere. Seguendo il trend, anche OpenAI ha dichiarato che rilascerà, con tempistiche non chiarissime ma probabilmente intorno al 2025, una possibilità simile.

Ad ogni modo, per quanto nascosta, l’opzione di opt-out dai colossi tech occidentali viene fornita – altre piattaforme, come Medium, applicano invece un’opzione di opt-in, premiata da una maggiorazione della percentuale di retribuzione dei propri articoli pubblicati. In altri regimi, e per altre applicazioni, questo non avviene: non vi è traccia di opzioni per tirarsi fuori dall’algoritmo ad esempio per la cinese TikTok, che invece si è adoperata coerentemente con il primo vero AI Act mai promulgato, quello dell’Impero di Mezzo, a inserire in maniera automatica un’etichetta “generato con AI” (ora disponibile anche su Instagram e Facebook, ma da inserire manualmente) ai contenuti che fanno utilizzo di IA generative.

Se in generale è molto complesso aprire le scatole nere di questi modelli, ancora meno trasparenti sono poi i modelli principali asiatici di Baidu, Zhipu (nuova entrante nell’agone del settore) e Tencent, di cui pochissimo è stato divulgato dalla Xinhua, l’agenzia di stato cinese, e su cui poche fonti si trovano anche tra gli analisti occidentali e orientali. Non in tutto il mondo è insomma possibile “negare il permesso”, o anche solo dichiarare di volerlo fare, senza finire per perdere punti nel sistema di credito sociale.